DeepSeek正在成為高校推動教育創新、提升科研水平和培養創新型人才的重要工具。眾多高校紛紛積極探索如何將DeepSeek融入教學、科研和管理等核心業務,以實現教育模式的升級和教育質量的飛躍。2月19日,天津大學正式推出私有部署的DeepSeek-R1 671B大模型,為全校師生及科研團隊提供了更為優質的服務,成為DeepSeek賦能高等教育的典型案例之一。

服務平臺部署方案

本次部署旨在面向全校師生提供基于DeepSeek-R1 671B非量化版本的大模型服務。該服務不僅支持基礎的自然語言處理任務,還具備多種高級功能,包括但不限于聯網搜索、公式生成、代碼生成等,以滿足不同學科背景用戶的需求。

為確保平臺能夠高效穩定地運行,系統設計了較高的并發處理能力與生成速度。具體而言,建設目標為支持同時請求數不低于100人的推理平臺,且保證每秒生成的Token數量不低于600個。這一配置旨在滿足大規模用戶訪問需求,同時保障實時性和用戶體驗。

平臺架構設計

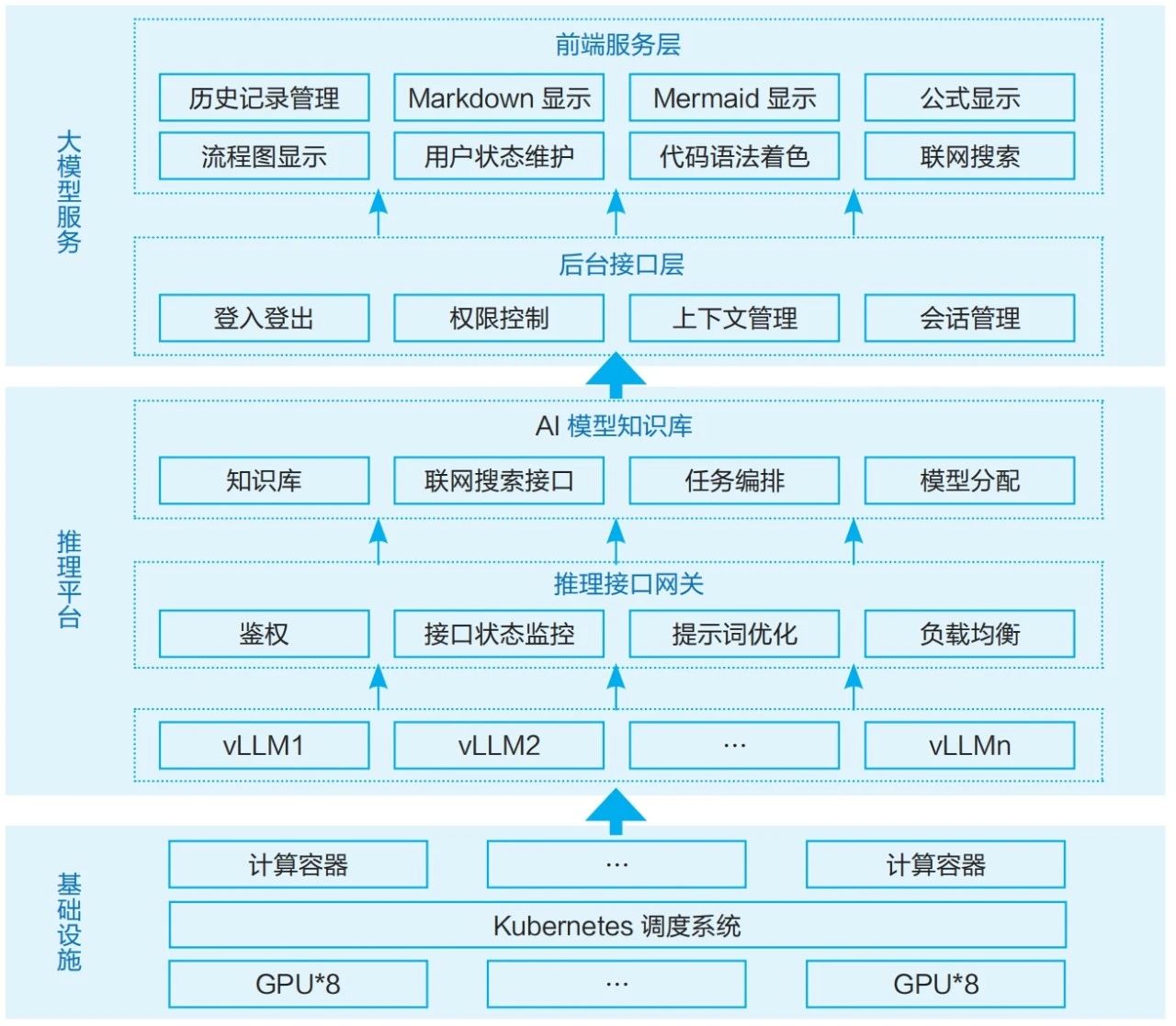

如圖1所示,系統自底向上可以分為基礎設施、推理平臺、大模型服務三個部分。

圖1 系統整體架構

基礎設施層提供了平臺運行所需的底層支持,系統依托于天津大學計算平臺,平臺提供了高性能的GPU計算資源,使用Kubernetes調度系統進行資源分配,從而提供開箱即用的高性能計算環境。這些基礎設施確保了平臺的穩定性和可擴展性,能夠處理大量的并發請求和復雜的大模型推理任務。

推理平臺建立在基礎設施提供的算力基礎上,是AI對話平臺的核心。平臺使用vLLM推理引擎提供多組大模型服務。推理接口網關作為推理平臺與外部系統交互的入口,負責鑒權、接口狀態監控、提示詞優化和負載均衡等任務,確保推理服務的穩定性和效率。

AI模型知識庫負責管理和調度AI模型的推理任務,包括知識庫、聯網搜索接口、任務編排和模型分配等功能。

大模型服務是用戶與系統交互的直接界面,在對話方面,通過自主開發的系統界面提供Markdown和Mermaid顯示、公式顯示、流程圖顯示、代碼語法著色等功能,使得對話更加直觀和規范。此外,該平臺還提供了接口管理,包括登錄登出、權限控制、上下文管理和會話管理和聯網搜索等功能,確保了用戶交互的安全性和連貫性。

推理服務部署

平臺構建了一個強大的計算集群,由15臺服務器組成,每臺服務器配備8塊顯存80GB的高性能顯卡,實現卡間高速互聯,提供卓越的計算性能與數據傳輸速率。為確保服務器之間的高效通信,集群采用了200Gb高速網絡鏈接,極大地提升分布式計算任務中的數據交換效率,特別是在需要大量數據交互的深度學習訓練場景下表現尤為突出。

軟件環境方面,所有機器均安裝了Ubuntu操作系統,能夠兼容各類科學計算軟件和工具。此外,為更好地管理和調度如此龐大的計算資源,平臺集成了天津大學計算平臺的服務,不僅能夠提供強大的算力支持,還通過其內置的容器部署功能實現了計算環境的快速配置與切換,大大簡化科研人員的操作流程,提高了資源利用效率。

在系統搭建工作完成后,團隊使用了vLLM包含的Benchmark工具進行了系統吞吐量測試。測試使用了ShareGPT_V3_unfiltered_cleaned_split數據集,從數據集中隨機取出30條文本內容,同時發送給一組三節點的推理模塊。經過多次測試,在并發數為30的情況下,一組三節點的集群能夠處理的總吞吐量在280token/s左右,每秒輸出詞元數為140個左右。測試結果表明,一組服務器可以支持30人同時流暢使用DeepSeek 671B模型進行單輪對話。對于多輪對話,由于上下文長度顯著增加,性能可能略有下降。

大模型應用中臺

大模型應用中臺能夠整合不同底層大模型的接口差異,實現各種內外部大模型的快速接入,并根據業務場景的數據安全要求選擇使用外部模型或私有化模型。此外,大模型應用中臺還具備智能知識庫分析能力,通過結合向量數據庫支持文本向量分段、大模型問答拆分、精準導入等多種知識錄入方式,提高答案的召回率和準確性,適應多種場景需求如問答、閱讀、生成等。同時,應用中臺提供任務可視化編排功能,允許通過圖形化界面輕松實現包含知識庫搜索、AI對話、關鍵詞提取、問題分類、API調用等模塊的復雜工作流,擴展構建AI智能體的能力。為了實現多渠道快速接入,平臺支持通過對話窗口、API等方式與各業務系統快速集成,為用戶提供全面的知識解答。

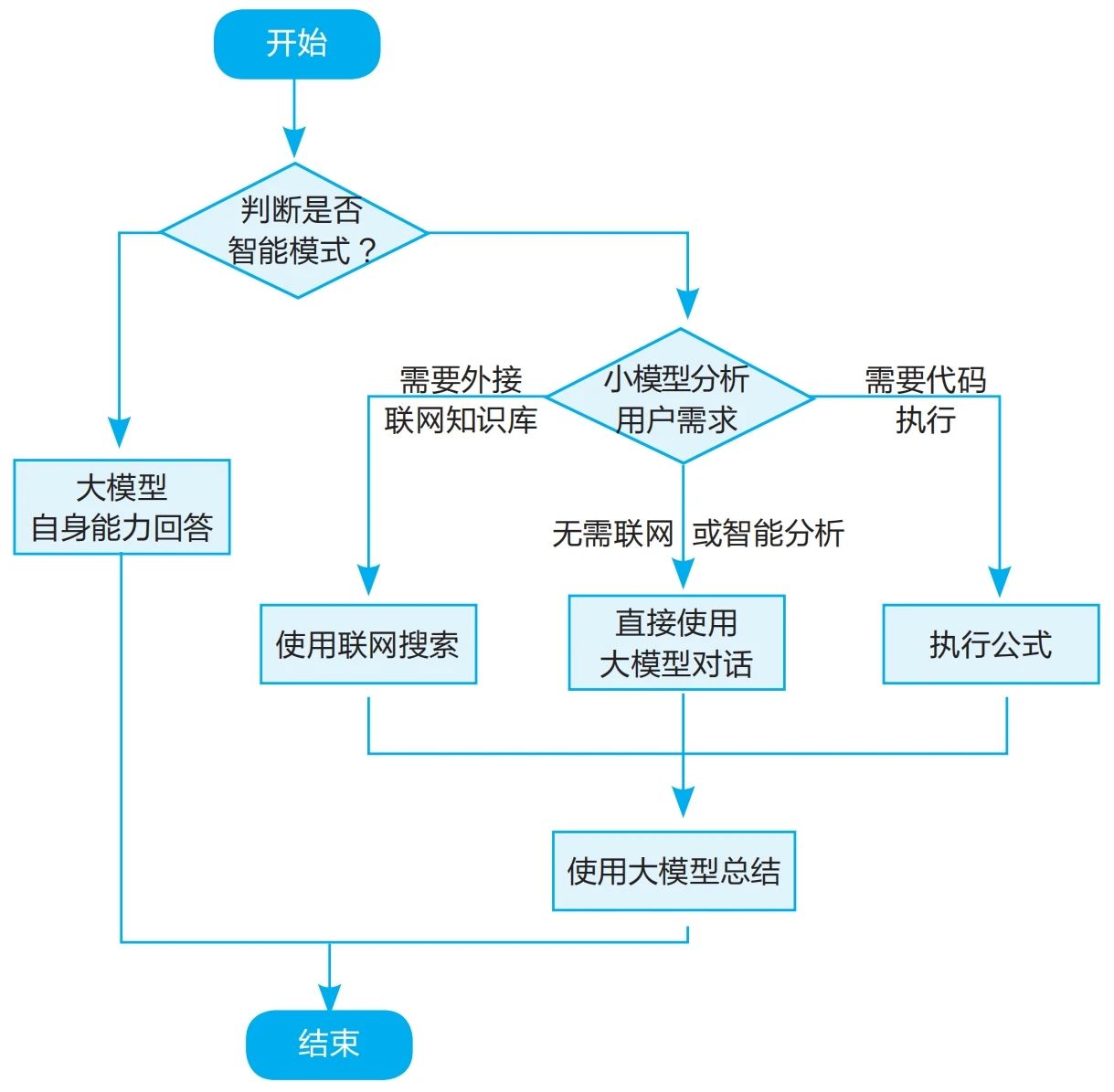

圖2是為學校設計的大模型應用中臺流程圖。用戶在默認情況下可以直接調用DeepSeek,使用大模型自身的能力回答問題。如果用戶選擇使用智能模式,系統將調用中臺的編排能力分析用戶需求,進而使用不同工具進行更細致的加工處理。在智能模式中,系統使用DeepSeek 7B小模型,分析用戶需求,根據用戶問題將需求分為“聯網搜索”“代碼執行”和“直接使用大模型能力對話”三種。針對聯網搜索,直接調用搜索接口,將接口返回值進行格式化處理后傳入大模型進行分析和總結。對于代碼執行需求,系統將用戶代碼抽取并傳送至獨立的沙箱進行代碼調用,計算完成后返回結果給大模型,進而回復用戶。

圖2 大模型應用中臺流程設計

大模型服務構建

系統對接了天津大學統一身份認證平臺,校內用戶無需注冊即可直接使用大模型服務,使用JWT實現了權限控制和登入登出功能。系統基于CAS協議與天津大學統一身份認證平臺進行交互,獲取用戶身份、學院等背景信息,作為大模型提示詞輸入到模型中臺,為大模型回答問題提供必要的背景知識,幫助其更準確地回答出用戶的問題,也使其回復的答案更加貼近用戶身份。

借助大模型中臺提供的推理和會話編排能力,后端使用Fast Api構建了一套接口,提供會話保存、上下文管理等功能。在收到用戶請求后,中臺將自動保存用戶請求和大模型返回值,并在下一輪對話中將前6輪對話的內容填充至大模型的上下文,借助DeepSeek長上下文的特點,提供更準確的對話信息。用戶權限和歷史會話使用JSON格式保存在MongoDB中。

運維分析及服務優化升級

為提升平臺的整體運行效率和服務質量,學校從多個維度開展了系統性能優化工作。通過負載均衡策略、斷開鏈接策略以及小模型過濾機制的綜合應用,平臺在資源分配、穩定性保障及計算成本控制等方面取得了顯著成效。

智能網關。為適應多組大模型共同提供服務,我校自主研發了一套智能網關系統,負責LLM請求的負載分配及健康監控。

其一,負載均衡策略。為提高系統的穩定性和響應速度,學校在智能網關層面引入了一種基于動態負載評估的優化策略。該策略通過實時收集各虛擬大語言模型(vLLM)節點的運行狀態數據,包括但不限于硬件負載、當前用戶請求數量、正在處理的用戶請求數量以及正在等待的用戶請求隊列長度,對各節點的實際負載進行全面評估。當新的用戶請求到達時,智能網關會根據已掌握的各項負載指標對所有節點進行排序,并選取負載最低的兩個節點,將用戶隨機分配到其中一個節點上進行處理。這一策略不僅能夠有效分散用戶請求壓力,避免單個節點過載,還能顯著提升系統的整體吞吐能力和資源利用率。

此外,為了進一步優化負載均衡效果,系統還引入了歷史負載數據分析機制。通過對過去一段時間內各節點的負載變化趨勢進行建模和預測,智能網關能夠在一定程度上提前調整資源分配策略,從而更好地應對突發流量高峰或局部負載不均的情況。

其二,斷開鏈接策略。為確保系統的健康運行并防止個別異常會話對整個節點造成負面影響,天津大學在智能網關中設計并實施了一種斷開鏈接策略。具體而言,智能網關會持續監控各節點的token生成情況。如果檢測到某個用戶會話長時間未能生成有效的token(例如超過預設的時間閾值),系統將主動斷開該會話連接,并釋放相關資源。這種機制可以有效避免因單個會話的異常行為(如死循環、超時或其他不可控因素)導致的資源浪費或節點阻塞問題,從而保障其他用戶的正常訪問體驗。

同時,為了減少對用戶體驗的影響,系統會在斷開會話前向用戶發送提示信息,說明原因并建議重新提交請求。此外,針對頻繁觸發斷開策略的用戶或會話類型,系統還會自動記錄相關日志,以便后續分析其潛在問題并優化處理邏輯。

輸入護欄。為降低大模型推理過程中的計算成本并提升系統效率,引入一種基于小模型的用戶問題預處理機制。在調用DeepSeek-R1 671B大模型之前,所有用戶輸入的問題首先會被傳遞給參數規模較小的DeepSeek-R1 7B模型進行初步判斷和分類。DeepSeek-R1 7B模型通過對問題內容的快速分析,能夠識別出無效問題(如無意義的字符輸入或重復提問)和不合規問題(如涉及敏感話題或違反學校政策的內容)。對于這些不符合要求的問題,系統將直接跳過大模型推理階段,并向用戶返回固定格式的提示信息,從而節省大量計算資源。

此外,在聯網搜索場景中,DeepSeek-R1 7B模型還承擔了判斷用戶問題是否需要外部網絡支持的任務。如果模型確定用戶問題可以通過本地知識庫或大模型自身能力解決,則直接進入下一階段的處理流程;反之,若問題需要依賴外部網絡資源(如實時新聞、學術數據庫等),系統才會啟動聯網搜索模塊。這種分層處理機制不僅提高了系統的響應速度,還顯著降低了對外部網絡資源的依賴性,增強了系統的魯棒性和可擴展性。

輸出約束與優化。通過明確規定大模型在回答時需遵循的規則和格式要求,可以有效提升回答的質量和可用性。學校使用提示詞優化輸出內容,主要設計包括規則約束和格式優化兩方面。

在規則約束方面,首先明確AI的身份和法律遵循要求,能確保其回答符合當地法律法規,特別是數據隱私等敏感問題,避免出現法律風險。確認AI處理中英文問題的能力,同時坦誠知識截止日期后的信息局限性,能讓用戶對其能力范圍有清晰認識,合理期待回答的準確性。要求提供全面且邏輯清晰的回答,并采用格式化輸出,可使信息呈現更有條理、易讀,面對模糊問題坦誠不確定性,體現誠實和專業。拒絕涉及非法、暴力、不適當內容的請求,維護道德和法律底線、保障用戶安全及隱私。同時,將大模型服務主要應用于高等教育行業并確保內容嚴謹性,能使其在專業領域發揮更大價值。

在輸出格式優化方面,遵循Markdown語法規則等格式要求,能讓回答在系統中正確解析和展示,如數學公式準確呈現、引用規范、內部推理清晰等,提升用戶體驗和回答的專業性。

聯網搜索。平臺集成了聯網搜索功能,用戶可使用該功能搜索互聯網上的內容,并使用大模型進行總結。聯網搜索功能需要配置網絡搜索引擎接口。學校研發了搜索引擎聚合接口服務,將部分公開的搜索結果和校內的內容平臺搜索引擎聚合,提供標準的搜索結果。大模型總結搜索內容后,需要在前端將引用內容展示給用戶,同樣需要相關的提示詞。

本次上線DeepSeek大模型服務,是天津大學邁向智能化教育的重要一步,但這也僅僅是一個起點。未來,學校將致力于將大模型服務與學校的教學、科研、管理等核心業務深度融合,打造更加智能、高效、個性化的教育生態系統。

基金項目:本文系2024年天津大學創新人才培養項目——基于大模型的研究生課程教學改革探索與實踐(YCX2024034)階段性研究成果。

來源:《中國教育網絡》2025年2-3合刊

作者:趙越1、趙滿坤2、張文彬1、于瑞國1(作者單位1為天津大學信息與網絡中心;2為天津大學智能與計算學部)

責編:陳榮